4.IK分词器插件

4.IK分词器插件

1.什么是IK分词器?

分词:即把一段中文或者别的划分成一个个的关键字,我们在搜索时候会把自己的信息进行分词,会把数据库中或者索引库中的数据进行分词,然后进行一个匹配操作,默认的中文分词是将每个字看成一个词,比如 “我爱发明” 会被分为 “我”, "爱",“发“,”名”,这显然是不符合要求的,所以我们需要安装中文分词器ik来解决这个问题。

IK提供了两个分词算法:ik_smart和ik_max_word,其中ik_smart为最少划分,ik_max_word为最细粒度划分

2.安装

安装步骤:

1、下载 https://github.com/medcl/elasticsearch-analysis-ik

2、下载完毕后,解压到到elasticsearch 插件中

3、重启elasticsearch

4、elasticsearch-plugin 可以通过这个命令查看加载的插件

5、使用kibana进行测试

3.查看不同的分词器效果

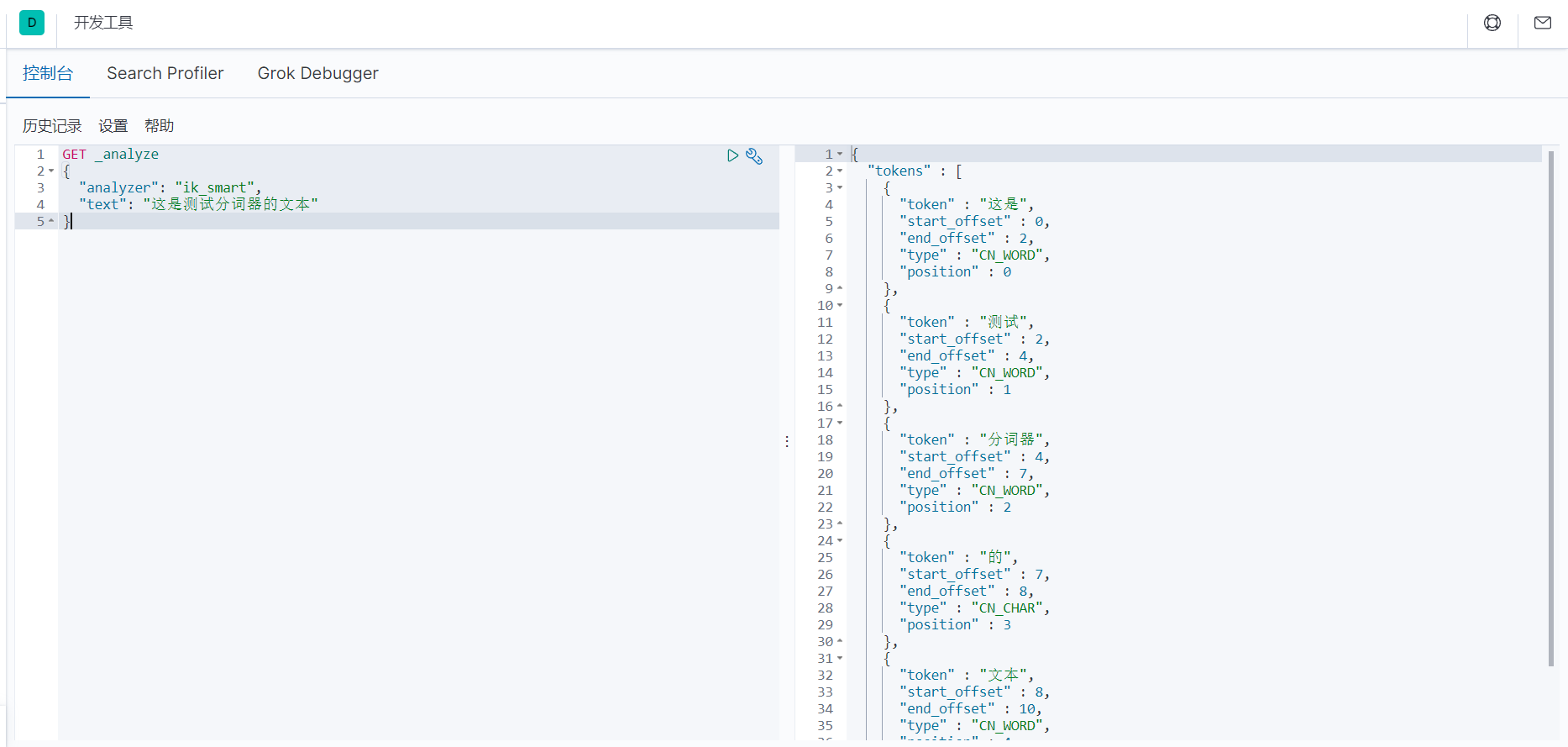

3.1.ik_smart 为最少切分

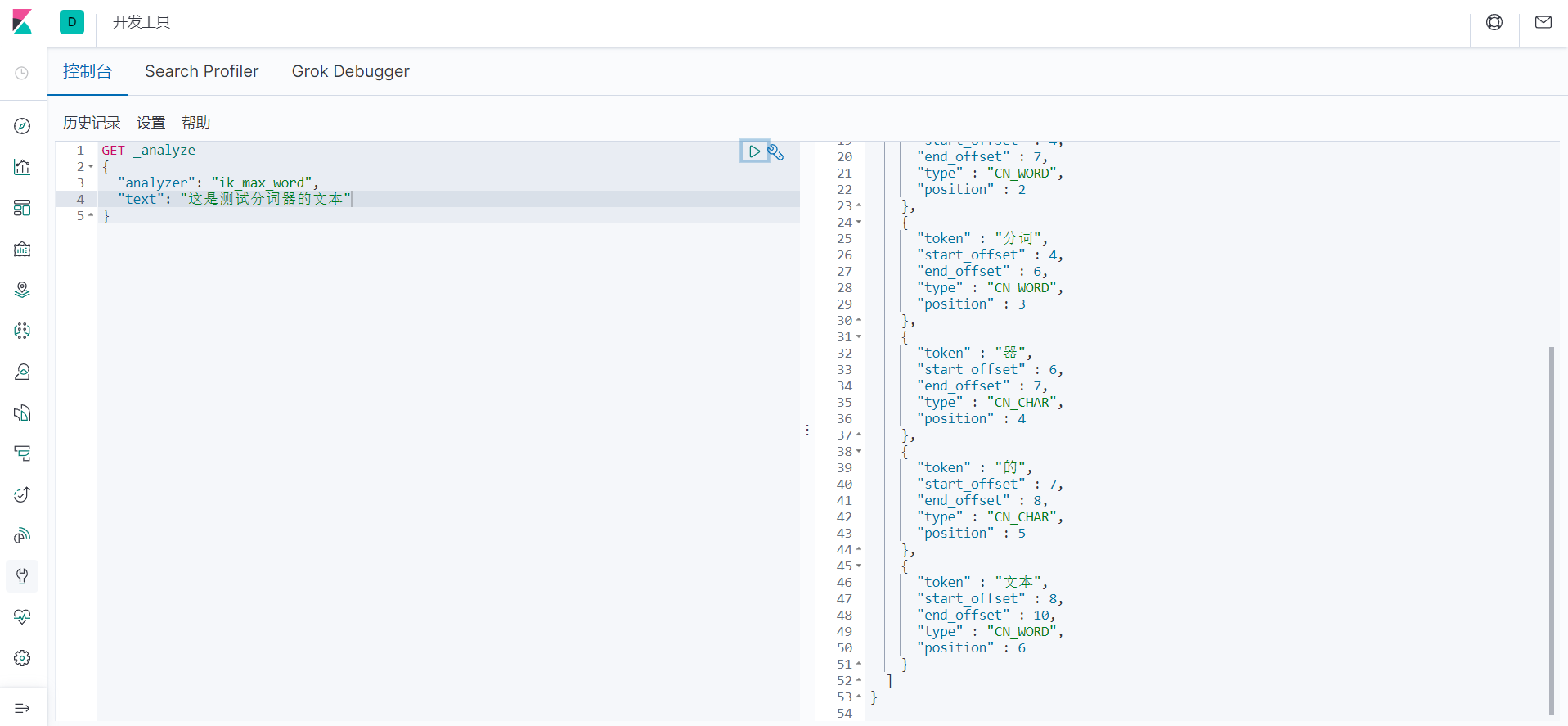

3.2.ik_max_word 为最细粒度划分,穷尽词库的可能!字典

3.3.ik分词器字典

IKAnalyzer.cfg.xml

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd">

<properties>

<comment>IK Analyzer 扩展配置</comment>

<!--用户可以在这里配置自己的扩展字典 -->

<entry key="ext_dict">zjzaki.dic</entry>

<!--用户可以在这里配置自己的扩展停止词字典-->

<entry key="ext_stopwords"></entry>

<!--用户可以在这里配置远程扩展字典 -->

<!-- <entry key="remote_ext_dict">words_location</entry> -->

<!--用户可以在这里配置远程扩展停止词字典-->

<!-- <entry key="remote_ext_stopwords">words_location</entry> -->

</properties>

4.Rest风格说明

评论

匿名评论

隐私政策

你无需删除空行,直接评论以获取最佳展示效果